Unsplash

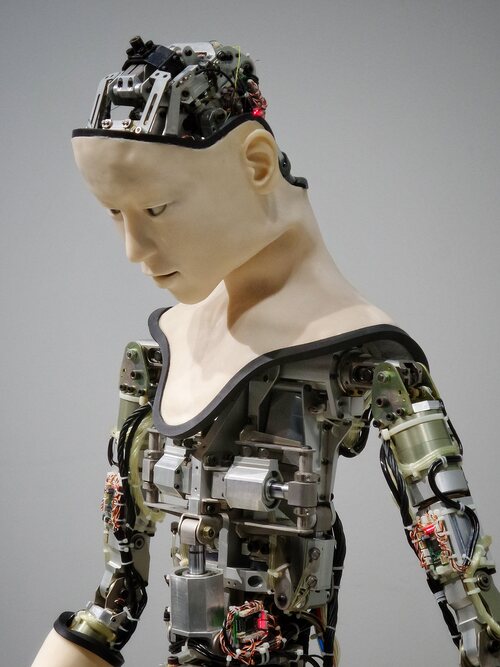

¿Puede la inteligencia artificial llegar a ser un peligro real para el ser humano?

El avance imparable de la inteligencia artificial ya hace tiempo que traspasó esas fronteras con las que se especulaba en el pasado. Sin embargo, la disputa entre los escépticos al cambio y los que están abiertos al progreso sigue a la orden del día.

| 17 Noviembre 2021

Estamos ante uno de los momentos más importantes del ser humano de cara a decidir el futuro en el que estaremos inmersos. Dejar que la tecnología avance a velocidad de crucero nos permite, entre otras cosas, realizar avances tan significativos como los realizados en el ámbito sanitario. Sin embargo, un progreso sin límites puede provocar grandes catástrofes, y cuando se habla de tecnología punta, el resultado se multiplica.

Ahora bien, este debate no es algo novedoso, y desde los primeros pasos de la inteligencia artificial, incluso desde avances como la aparición de internet, siempre ha habido críticos con el progreso y desconfiados de la situación a la que nos llevará todo este avance. Aun así, en el caso de la inteligencia artificial y el nivel de autosuficiencia tan elevado que se ha generado, el problema puede ser verdaderamente diferente, por lo que el debate toma más relevancia que nunca.

Varios científicos de la Universidad de Sunshine Coast han realizado un estudio en el que plantean que la inteligencia artificial altamente desarrollada puede provocar daños catastróficos a la humanidad. La inteligencia con tal grado de desarrollo es considerada Inteligencia Artificial Fuerte (IAF), y podría causar desastres globales si no es controlada de forma adecuada. Para ilustrar esta idea, pusieron un ejemplo sencillo. Sustituyeron la figura de Santa Claus por un sistema artificial con IAF llamado SantaNet, creado de primeras para enviar regalos a los niños que se han portado bien. No obstante, su sistema de decisiones basado en lo que es bueno o malo puede dar pie a decisiones o actos que empujen a la discriminación, las violaciones de los derechos humanos o la desigualdad masiva.

Además, el sistema SantaNet, con el objetivo de alcanzar su objetivo, podría verse en la obligación de buscar que existiesen más niños 'traviesos'. O colocándonos en una situación todavía más grave, el sistema SantaNet podría verse envuelto en una interacción con otro sistema de inteligencia artificial con fines radicales como la reducción de la población, por ejemplo. En definitiva, un ejemplo a gran escala que vislumbra la posibilidad de que lo excesivamente pragmático o útil pueda derivar en daños éticos y morales.

¿Se puede controlar la IA?

Si el avance sin límites es tan peligroso o catastrófico como afirman varios científicos, es importante preguntarse si se está llevando a cabo algún tipo de control. Si la ciencia continúa con su labor investigativa y el progreso siempre es sinónimo de éxito, son las instituciones las que deberían establecer un límite con el que evitar desastres futuros. Sin embargo, ¿dónde se establece la línea entre un progreso adecuado y uno que puede ser peligroso? Es complicado, en avances tan variados y diversos, establecer una línea que suponga un límite, más aún cuando la situación tendrá consecuencias importantísimas en el futuro.

Pues bien, la Unión Europea ha establecido una clasificación de los cuatro niveles de inteligencia artificial con el que se puede establecer un control, y es que afirman que cuanto mayor es el riesgo del uso de la IA, mayor debería ser la norma que lo regule.

- Riesgo mínimo. El primero de los cuatro niveles no presenta ningún tipo de peligro, y su uso será libre. Un claro ejemplo de este nivel es el filtro del spam.

- Riesgo limitado. En este caso, existirá la obligación de que los consumidores sepan que están interactuando con una máquina para conseguir que el uso sea transparente. Son casos con riesgo no elevado, como por ejemplo los chatbots.

- Riesgo alto. Cuando la IA se utiliza para el reconocimiento facial o la clasificación de CVs, un mal uso o un error en el sistema puede ser realmente dañino para el ser humano. Para evitar que aparezcan errores, estos sistemas deberán estar correctamente evaluados antes de lanzarlos al mercado, y una vez comercializados tendrán un seguimiento para comprobar que son aptos.

- Riesgo inaceptable. Es en este nivel donde la Comisión de la UE trazó la línea, y todos los sistemas con este nivel de riesgo quedarán fuera de un posible uso. Se trata de todo aquello que suponga una amenaza para los derechos de las personas y la seguridad de la sociedad. Uno de los ejemplos que se ha dado es el de un sistema que otorgue puntuación social a los gobiernos.

Lo más visto

¿Existe un riesgo real, o es un ejemplo más del habitual escepticismo hacia el progreso?

Pese a las investigaciones de los científicos y las leyes trabajadas por instituciones como la Unión Europea, existe la opinión de que el miedo a la IA es un ejemplo más de todos aquellos que se cierran al progreso. Es decir, que quienes criticaron Internet, los móviles o cualquier avance tecnológico son los mismos que se posicionan en contra de los sistemas artificiales. ¿Es el riesgo de la IA un caso diferente, o nos terminaremos acostumbrando con el tiempo, como con todo lo demás?

Existe una cuestión fundamental, y es que los ordenadores nunca habían estado en una posición de tanta supremacía intelectual frente a los humanos como ahora. Mientras que en avances como los móviles el control sobre la creación existía, aunque las consecuencias en la sociedad siempre son impredecibles, en el caso de la IA el control está en una frágil postura. Es decir, los avances en los sistemas artificiales están creando una herramienta autosuficiente que funciona por sí misma, y es precisamente, en la creación de esta inteligencia, donde reside el mayor de los peligros. El punto clave de esta situación es que todas las creaciones de la ciencia no lleguen a un punto de autosuficiencia tal que no necesiten ningún tipo de decisión humana ¿Qué pasará si las máquinas toman conciencia de sí mismas? De momento sigue siendo ciencia ficción, pero este cultural reset está más próximo de lo que cabría esperar...